Un report del ricercatore di sicurezza Johann Rehberger ha evidenziato una grave vulnerabilità nel sistema di memoria a lungo termine di ChatGPT.

l’analisi tecnica

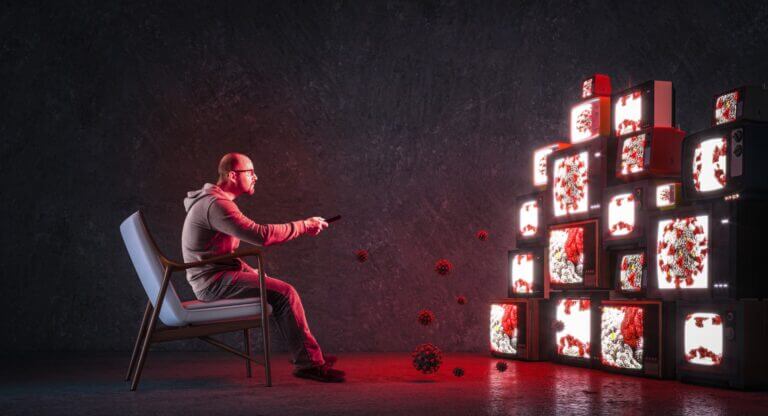

AI e falsi ricordi: il problema della sicurezza nella memoria a lungo termine di ChatGPT

La capacità degli attaccanti di manipolare la memoria a lungo termine di ChatGPT attraverso tecniche di “prompt injection indiretta” apre scenari rilevanti per la sicurezza. Se l’AI può memorizzare informazioni false e agire basandosi su di esse, le implicazioni per chi si affida al servizio per attività mission-critical sono preoccupanti

Esperto di AI Security, Consulente dell'Unione Europea

Continua a leggere questo articolo

Who's Who

Argomenti

Canali

Con o Senza – Galaxy AI per il business